Paikallinen tekoäly – hiljainen vallankumous koneillamme

Kun puhutaan tekoälystä, suurin osa keskustelusta pyörii pilvipalveluiden ympärillä. Mutta pinnan alla kytee toinen trendi: paikallinen tekoäly, eli mallit jotka pyörivät käyttäjän omalla koneella. Tämä ei ole enää vain nörttien leikkikenttä, vaan miljoonien käyttäjien arkea.

Globaalisti tarkkaa käyttäjämäärää ei ole, mutta mittareita kyllä:

- AI-PC:t yleistyvät: 14% vuoden 2024 ja 31% vuoden 2025 kaikista PC-toimituksista oli AI-PC:itä, joissa on sisäänrakennettu tekoälykiihdytin. Arvio vuodelle 2026 on 50%.

- Ollama-lataukset: yksittäisiä malleja on ladattu kymmeniä miljoonia kertoja. Esimerkiksi Llama 3.1 -mallia noin 99 miljoonaa kertaa.

- Yhteisöt kasvavat: Redditin r/LocalLLaMA-ryhmässä on yli puoli miljoonaa jäsentä.

Kenellä ja missä?

Yksilöt ja kehittäjät hyödyntävät työkaluja kuten Ollama, LM Studio ja text-generation-webui. Näillä saa käyttöön helppokäyttöisen paikallisen chatin tai koodiapurin.

Yhteisöt jakavat kokemuksiaan esimerkiksi LocalLLaMA-foorumeilla ja GitHubissa, missä jaetaan malleja, kvantisoituja painoja ja ohjeita.

Organisaatiot pilotoivat on-premise-ratkaisuja etenkin tietosuojan, kustannusten ja latenssin takia.

Miten käytän paikallista tekoälyä – LM Studio ja Ollama Windows 11:ssä

Tekoälysovellusten suuret kielimallit esim. GPT-5 toimivat suurissa datakeskuksissa. Moni ajattelee, että tekoäly on vain verkossa toimiva palvelu, mutta todellisuudessa voit käyttää sitä myös täysin ilman nettiyhteyttä. Siihen tarvitaan paikallinen tekoälysovelluksen asennus tietokoneelle ja tarvittavat paikalliset kielimallit. Tämä voi olla hyödyllistä esimerkiksi silloin, kun matkustat, teet töitä mökillä tai haluat pitää tietosi vain omalla koneellasi. Tämä voisi olla myös skenaario tilanteesta, kun netti ei toimi ollenkaan (kyberhyökkäys, sotatila jne).

Tässä käyn läpi, miten saat asennettua paikallisen tekoälyn Windows 11 -tietokoneelle, jossa on seuraava kokoonpano:

- Muisti: 32 GB RAM

- Näytönohjain: 4 GB VRAM

- Prosessori: AMD Ryzen 5 tai Intel i5

- Levytila tekoälylle: 1 TB SSD

Näillä spekseillä voit ajaa hyvin 7 miljardin parametrin malleja (7B) ja joitain suurempia kvantisoituja malleja. Tällä kokoonpanolla löytyy jo hyvin paljon kannettavia tietokoneita. Pöytäkoneet voidaan varustaa hyvin paljon suuremmalla RAM:lla ja tehokkaalla näytönohjaimella (pelikoneet). Mitä enemmän RAM-muistia ja näytönohjaimen VRAM-muistia, sitä paremmin ja isompia kielimalleja voidaan käyttää.

Paikallinen tekoälysovellus tällä raudalla ei toimi niin nopeasti kuin verkossa olevat ChatGPT, Gemini tai Copilot, mutta silloin kun ne eivät ole saatavilla, on sinulla paikallinen versio omassa koneessa aina valmiina.

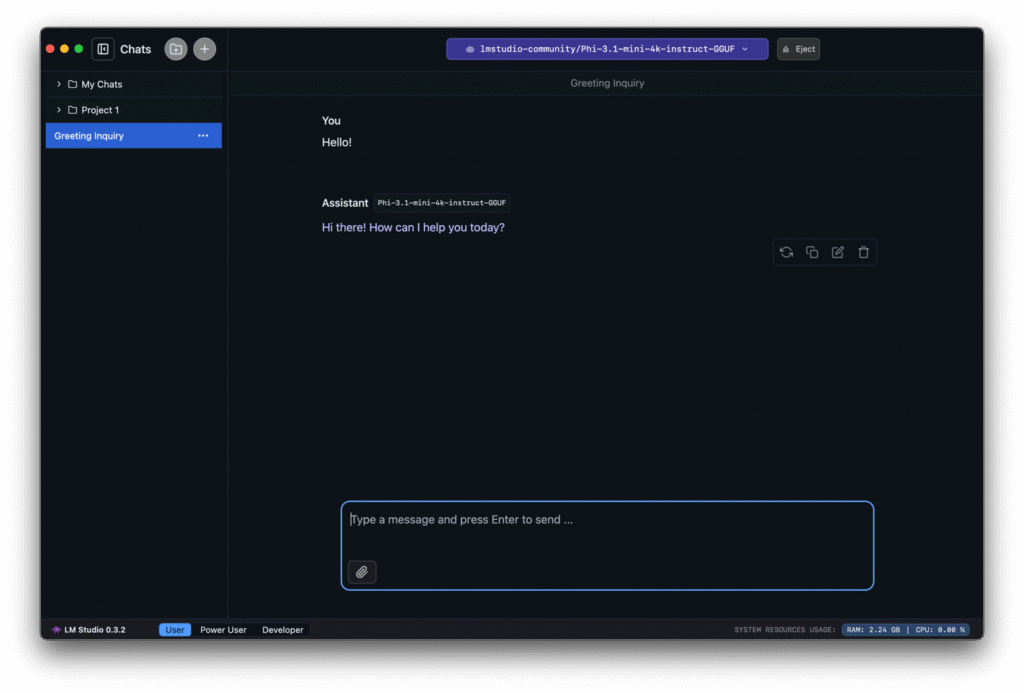

Vaihtoehto 1: LM Studio

LM Studio tarjoaa graafisen käyttöliittymän, jonka kautta voit helposti ladata ja ajaa erilaisia kielimalleja.

Asennusohjeet:

- Mene osoitteeseen lmstudio.ai.

- Lataa Windows-versio (.exe).

- Asenna ohjelma ohjatun asennuksen mukaisesti.

- Käynnistä LM Studio ja avaa mallien kirjasto.

- Valitse ja lataa haluamasi kielimallit. Ne tallentuvat koneelle, joten ne toimivat jatkossa offline-tilassa.

Vaihtoehto 2: Ollama

Ollama on komentorivipohjainen sovellus, joka toimii vähän kuin “Docker tekoälymalleille”: mallit paketoidaan helposti asennettaviksi ja ajettaviksi kokonaisuuksiksi.

Asennusohjeet:

- Mene sivulle ollama.ai.

- Lataa Windows-versio ja asenna ohjelma.

- Avaa PowerShell ja testaa komennolla: ollama run llama2

- Tämä lataa ja käynnistää LLaMA 2 -mallin.

- Kun malli on ladattu, sitä voi käyttää täysin ilman nettiä.

Kielimallien suosituksia

Alla mallilistaukset molemmille sovelluksille. Osa toimii erityisen hyvin englanniksi, osa taas soveltuu paremmin suomenkieliseen käyttöön. Nämä mallit toimivat 32GB RAM, 4GB VRAM kokoonpanolla.

LM Studio -mallit

Hyvin englanniksi toimivat:

- Mistral 7B Instruct – nopea ja monipuolinen yleismalli.

- LLaMA 2 7B Chat – suosittu keskustelumalli.

- GPT4All Falcon 7B – kevyt ja käytännöllinen malli.

- Nous Hermes 13B – laadukas keskustelumalli (kvantisoituna toimii).

- OpenChat 3.5 7B – erinomainen ohjeistettuihin tehtäviin.

Hyvin suomeksi toimivat:

- Mistral 7B multilingual – tukee hyvin suomea ja muita eurooppalaisia kieliä.

- XGLM 7.5B – monikielinen malli, sisältää suomen.

- LLaMA 2 multilingual fine-tuned – parannettu monikielinen versio.

- BLOOMZ 7B1 – monikielinen malli, joka osaa myös suomea.

Ollama -mallit

Hyvin englanniksi toimivat:

ollama run mistral– nopea ja laadukas yleismalli.ollama run llama2– keskustelumalli.ollama run codellama– erikoistunut koodiavustaja.ollama run orca-mini– kevyt Microsoftin ohjeistettu malli.ollama run phi– Microsoftin pieni, mutta tarkka kielimalli.

Hyvin suomeksi toimivat:

ollama run mistral– monikielinen, toimii hyvin myös suomeksi.ollama run bloom– BLOOM-malli, erinomainen monikielisyydessä.ollama run gemma– Googlen uusi malli, vahva monikielinen osaaminen.ollama run llama2(multilingual fine-tuned) – suomen tuki parantunut.ollama run xglm– monikielinen malli, sisältää suomen.

Miksi paikallinen?

Paikallisessa käytössä yhdistyy kolme isoa etua:

- Tietosuoja: data pysyy omalla koneella.

- Nopeus ja offline-toiminta: vasteaika paranee, eikä nettiä tarvita (nopea AI-PC, jossa paljon muistia).

- Kustannukset: vakioiduissa kuormissa paikallinen infra voi olla edullisempi kuin jatkuva pilvipalvelu.

Käyttötarkoituksia

Edellämainittu oli esimerkki LM Studio ja Ollama asennuksesta, mutta voidaan laajentaa keskustelua käyttötarkoituksesta:

Koodiapurit: refaktorointi, unit-testit, commit-viestit – ilman pilvidataan liittyviä huolia.

RAG (Retrieval-Augmented Generation): omien dokumenttien ja tietokantojen yhdistäminen malliin.

Offline-assarit: kieltenopiskelu, luonnostelu ja nopea apu ilman nettiä.

Yritykset: tietosuojatut chatbotit, sopimusanalyysi, sisäinen hakutoiminto.

Edge-käyttö: teollisuuden laitteissa paikallinen inferenssi ilman verkkoyhteyttä.

Millaisilla kokoonpanoilla?

Paikallisen tekoälyn pyörittämiseen ei aina tarvita supertietokonetta:

- Kevyt taso (mobiili, CPU/NPU): 1–8 miljardin parametrin mallit pyörivät jo puhelimessa kvantisoituina.

- Keskitason PC (RTX 4070, 12–16 GB VRAM): 7–14B mallit sujuvasti, 22–32B kompromisseilla.

- Korkean tason PC (RTX 4090, 24 GB VRAM tai M3 Max/Ultra): 32B toimii hyvin, 70B onnistuu rajoitetusti.

- Moni-GPU työasemat ja palvelimet: 70B+ mallit täydellä tarkkuudella, usein yrityskäytössä.

Kvantisoidut mallit (esim. 4-bittiset GGUF-formaatit) mahdollistavat huomattavasti pienemmän muistitarpeen – 7B-malli voi pyöriä vain 4 gigatavulla VRAMia.

Mihin suuntaan mennään?

7–14B-mallit riittävät suurimmalle osalle käyttäjistä.

32–70B-mallit avaavat syvemmän päättelyn ja pitkän kontekstin, mutta vaativat enemmän rautaa.

Ekosysteemi kypsyy: Apple MLX, Intel OpenVINO ja AMD:n ROCm helpottavat käyttöä. NVIDIA hallitsee edelleen markkinaa, mutta vaihtoehtoja syntyy.

Paikallinen tekoäly on siirtynyt kokeilusta arjen työkaluksi. Se on hiljainen vallankumous, joka tapahtuu omissa koneissamme – ja se näyttää vain kiihtyvän. Seuraavaksi kysymys ei ehkä ole enää voiko mallia pyörittää paikallisesti, vaan miksi käyttäisit enää pilveä jos kaikki tarvittava on taskussasi tai työpöydälläsi.

Lisälinkit:

LocalAI

LM Studio

Ollama

Hugging Face

GPT4All